Tìm hiểu sitemap và robots.txt là gì, vai trò quan trọng trong SEO và cách thiết lập hiệu quả cho website WordPress. Cải thiện thứ hạng Google ngay hôm nay. Để website WordPress thân thiện với công cụ tìm kiếm và đạt hiệu quả SEO cao, hai yếu tố kỹ thuật không thể bỏ qua là Sitemap và Robots.txt. Đây là hai tệp giúp điều hướng bot Google hiểu và thu thập dữ liệu website tốt hơn. Cùng websitedanang khám phá chi tiết và cách tối ưu hai công cụ này cho SEO.

1. Sitemap là gì?

1.1. Định nghĩa sitemap

Sitemap (sơ đồ trang web) là một tệp dữ liệu dạng XML chứa danh sách các URL quan trọng trên website mà bạn muốn các công cụ tìm kiếm như Google, Bing, Yahoo… thu thập và lập chỉ mục. Sitemap đóng vai trò như một bản đồ chỉ đường cho các bot tìm kiếm (crawler), giúp chúng hiểu rõ cấu trúc của website và truy cập được những trang quan trọng mà bạn muốn hiển thị trên kết quả tìm kiếm.

Sitemap không hiển thị cho người dùng mà chỉ phục vụ cho các công cụ tìm kiếm. Nó có thể bao gồm các loại nội dung như: trang, bài viết, hình ảnh, video, danh mục, sản phẩm…

1.2. Vai trò của Sitemap trong SEO

Sitemap không trực tiếp cải thiện thứ hạng từ khóa, nhưng gián tiếp góp phần tối ưu SEO bằng cách hỗ trợ Google và các công cụ tìm kiếm hiểu và lập chỉ mục nội dung website của bạn hiệu quả hơn.

Dưới đây là các lợi ích chính:

Hướng dẫn bot tìm kiếm thu thập dữ liệu. Sitemap giúp bot xác định những trang nào là ưu tiên, tránh bỏ sót những trang quan trọng, đặc biệt là các trang:

- Mới tạo, chưa có nhiều backlink nội bộ.

- Ẩn sâu trong cấu trúc website.

- Được cập nhật nội dung thường xuyên.

Tăng tốc độ index nội dung: Khi bạn xuất bản bài viết mới hoặc chỉnh sửa một trang cũ, Google sẽ không thể biết ngay lập tức. Sitemap sẽ gửi tín hiệu đến bot rằng có nội dung mới cần thu thập, từ đó giúp quá trình index diễn ra nhanh hơn, rút ngắn thời gian xuất hiện trên Google.

Thông báo cập nhật quan trọng. Ngoài việc liệt kê các URL, sitemap còn chứa thông tin bổ sung như:

- Ngày cập nhật lần cuối.

- Tần suất cập nhật.

- Mức độ ưu tiên so với các trang khác.

Những thông tin này giúp Google xác định trang nào nên được thu thập thường xuyên hơn, ưu tiên những nội dung có giá trị mới.

Hỗ trợ các website lớn hoặc thương mại điện tử: Với những website có hàng trăm, hàng nghìn trang, sitemap đóng vai trò rất quan trọng trong việc tổ chức dữ liệu, đảm bảo không bị sót nội dung trong quá trình crawl.

1.3. Cách tạo Sitemap cho website WordPress

Việc tạo sitemap trong WordPress khá đơn giản, đặc biệt khi bạn sử dụng các plugin hỗ trợ SEO. Dưới đây là các cách phổ biến:

Sử dụng plugin Yoast SEO: Sau khi cài đặt và kích hoạt, Yoast tự động tạo sitemap. Có thể bật/tắt sitemap và chỉnh sửa trong mục: SEO > Cài đặt > Sitemap.

Sử dụng Rank Math SEO: Tương tự Yoast, Rank Math cũng tự động tạo sitemap. Có thể thiết lập nhiều loại sitemap: bài viết, trang, sản phẩm, hình ảnh…

Sử dụng plugin Google XML Sitemaps: Đây là plugin chuyên biệt chỉ dành cho tạo sitemap XML. Giao diện đơn giản, nhẹ, dễ cấu hình.

Gửi sitemap lên Google Search Console. Sau khi đã tạo xong sitemap, bước tiếp theo là gửi sitemap cho Google để đảm bảo các bot có thể đọc và bắt đầu thu thập dữ liệu:

- Truy cập Google Search Console.

- Chọn website bạn cần khai báo.

- Chọn mục Sơ đồ trang web (Sitemaps) ở menu bên trái.

- Nhập đường dẫn đến sitemap (ví dụ: sitemap_index.xml) và nhấn Gửi.

- Theo dõi tình trạng sitemap để phát hiện lỗi hoặc trang chưa được lập chỉ mục.

Kiểm tra định kỳ để đảm bảo hiệu quả

- Đảm bảo sitemap không chứa các liên kết 404 hoặc redirect.

- Không đưa vào sitemap những trang noindex hoặc không quan trọng.

- Sử dụng công cụ URL Inspection trong Search Console để kiểm tra tình trạng index các URL chính.

2. Robots.txt là gì?

2.1. Định nghĩa Robots.txt

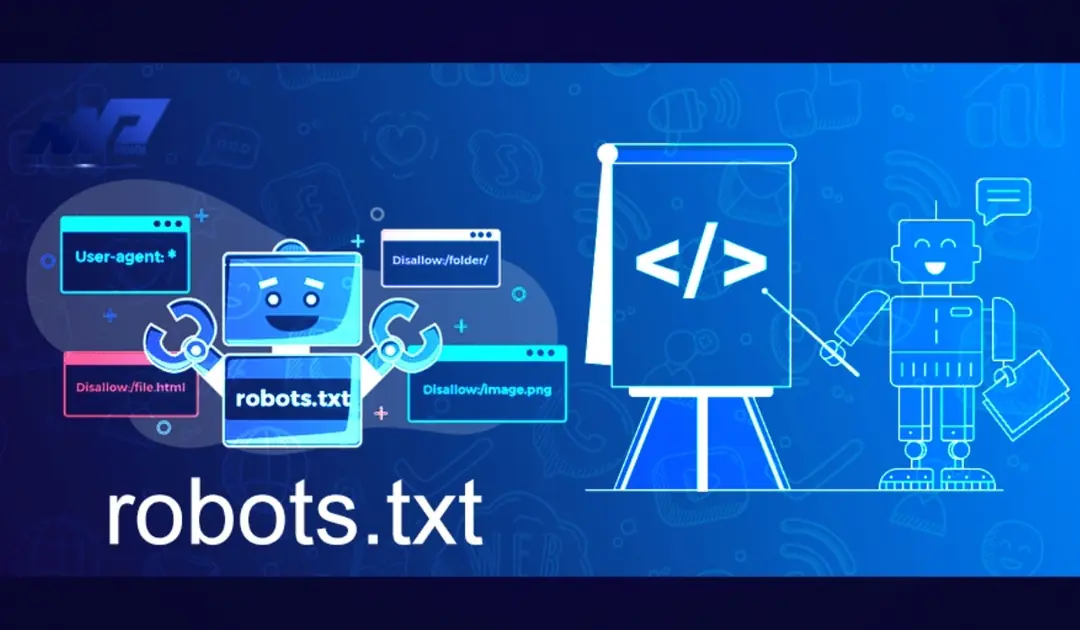

Robots.txt là một tệp văn bản dạng TXT, nằm trong thư mục gốc của website (ví dụ: https://tenmiencuaban.com/robots.txt). Tệp này được sử dụng để giao tiếp với các công cụ tìm kiếm, hướng dẫn các trình thu thập dữ liệu (crawler, bot) nên hoặc không nên thu thập nội dung nào trên trang web của bạn.

Khác với sitemap – nơi chỉ rõ các trang nên thu thập, robots.txt lại là nơi quy định những phần cần hạn chế hoặc cấm truy cập.

2.2. Vai trò của Robots.txt trong SEO

Dù tệp robots.txt không ảnh hưởng trực tiếp đến thứ hạng từ khóa, nó là một phần quan trọng trong chiến lược SEO kỹ thuật (Technical SEO), giúp quản lý tài nguyên crawl hiệu quả và tránh những lỗi không mong muốn trong quá trình lập chỉ mục.

Kiểm soát quá trình thu thập dữ liệu (crawl)

Công cụ tìm kiếm có giới hạn về số lượng trang có thể crawl trong một khoảng thời gian – gọi là crawl budget. Với robots.txt, bạn có thể ngăn bot lãng phí tài nguyên vào những khu vực không quan trọng như:

- /wp-admin/

- /cgi-bin/

- Trang kết quả tìm kiếm nội bộ (?s=keyword)

- Giỏ hàng, thanh toán (trong web thương mại điện tử)

Việc này giúp bot tập trung crawl các trang nội dung có giá trị SEO cao như bài viết, trang sản phẩm, landing page.

Hỗ trợ bảo mật và tránh rò rỉ thông tin không cần thiết. Robots.txt có thể ngăn công cụ tìm kiếm lập chỉ mục những trang chứa thông tin nhạy cảm, chẳng hạn như:

- Trang quản trị, đăng nhập.

- Trang dành cho nội bộ, không công khai.

- File tài nguyên riêng tư không dành cho công chúng.

Lưu ý: Robots.txt chỉ “yêu cầu” bot không truy cập, chứ không chặn truy cập tuyệt đối. Những trang này vẫn có thể bị lộ nếu có backlink trỏ đến. Vì vậy, không nên dùng robots.txt để ẩn thông tin thực sự nhạy cảm. Hãy dùng biện pháp bảo mật khác như xác thực đăng nhập hoặc noindex + mật khẩu.

Tối ưu hóa tốc độ index. Bằng cách giới hạn bot khỏi những nội dung dư thừa, bạn giúp Googlebot dành nhiều thời gian hơn cho các trang quan trọng, từ đó tăng khả năng được index và cải thiện chất lượng thu thập dữ liệu tổng thể.

2.3. Cách thiết lập Robots.txt hiệu quả cho WordPress

Việc tạo và chỉnh sửa robots.txt trong WordPress khá đơn giản, bạn có thể thực hiện bằng 3 cách phổ biến:

Cách 1: Qua FTP hoặc File Manager

- Truy cập thư mục gốc (public_html hoặc root domain).

- Tạo một file có tên robots.txt.

- Dán nội dung hướng dẫn vào file này và lưu lại.

Cách 2: Sử dụng plugin Yoast SEO

- Truy cập SEO > Công cụ > Trình chỉnh sửa tệp.

- Tại mục robots.txt, chỉnh sửa nội dung theo nhu cầu.

- Nhấn Lưu thay đổi vào robots.txt.

Cách 3: Rank Math SEO

- Vào Rank Math > General Settings > Edit robots.txt

- Chỉnh sửa nội dung và lưu.

Lưu ý khi sử dụng Robots.txt:

- Không chặn nhầm các trang quan trọng như trang sản phẩm, bài viết, danh mục cần SEO.

- Không dùng để ẩn thông tin bí mật. Dùng thêm noindex hoặc xác thực nếu cần.

- Kiểm tra thường xuyên bằng Google Search Console > Công cụ kiểm tra URL hoặc công cụ “robots.txt Tester”.

Sitemap và Robots.txt ảnh hưởng đến SEO thế nào?

Cả Sitemap và Robots.txt đều là hai công cụ quan trọng trong SEO kỹ thuật, hỗ trợ công cụ tìm kiếm hiểu, thu thập và lập chỉ mục nội dung trên website một cách thông minh hơn. Tuy không trực tiếp tác động đến thứ hạng từ khóa, nhưng việc thiết lập đúng và hợp lý sẽ góp phần cải thiện khả năng hiển thị và hiệu quả SEO tổng thể.

So sánh ảnh hưởng của Sitemap và Robots.txt đến SEO

| Yếu tố | Sitemap | Robots.txt |

| Hỗ trợ index trang mới | ✅ Có | ❌ Không |

| Giúp Google hiểu cấu trúc website | ✅ Có | ❌ Không |

| Ngăn thu thập trang không mong muốn | ❌ Không | ✅ Có |

| Tối ưu ngân sách thu thập (Crawl Budget) | ⚠️ Gián tiếp | ✅ Trực tiếp |

| Tác động trực tiếp đến thứ hạng SEO | ❌ Không | ❌ Không |

| Hỗ trợ SEO kỹ thuật | ✅ Có | ✅ Có |

Kết hợp cả hai một cách hợp lý sẽ nâng cao hiệu quả thu thập dữ liệu, tối ưu hóa crawl budget và đảm bảo các trang quan trọng được ưu tiên index. Điều này đặc biệt quan trọng với các website:

- Có hàng trăm đến hàng nghìn URL.

- Cập nhật nội dung thường xuyên.

- Sử dụng WooCommerce hoặc có cấu trúc phân tầng phức tạp

4. Những lưu ý khi sử dụng Sitemap và Robots.txt

- Tránh chặn nhầm các trang quan trọng trong Robots.txt. Chặn nhầm các URL quan trọng như bài viết, sản phẩm hoặc trang danh mục trong robots.txt có thể khiến Google không thể thu thập và lập chỉ mục, dẫn đến mất thứ hạng và giảm traffic. Trước khi lưu file, hãy kiểm tra kỹ các dòng Disallow: và sử dụng công cụ kiểm tra robots.txt của Google Search Console để đảm bảo không có trang cần SEO bị chặn.

- Cập nhật sitemap khi thay đổi cấu trúc website

Mỗi khi bạn thêm, xóa, đổi URL hoặc thiết lập chuyển hướng nội dung, sitemap cần được cập nhật để phản ánh đúng cấu trúc hiện tại. Điều này giúp Google thu thập dữ liệu chính xác, tránh lỗi 404 hoặc index sai nội dung. Nếu dùng plugin như Yoast SEO hay Rank Math, sitemap thường cập nhật tự động, nhưng bạn vẫn nên kiểm tra định kỳ để đảm bảo không có sai sót. - Theo dõi định kỳ trong Google Search Console

Google Search Console giúp bạn theo dõi tình trạng sitemap, robots.txt và khả năng index của website. Hãy thường xuyên kiểm tra lỗi sitemap, tình trạng crawl và dùng công cụ URL Inspection để phát hiện sớm các sự cố. Việc này giúp đảm bảo nội dung luôn được Google thu thập và hiển thị chính xác. - Không dùng Robots.txt để giấu nội dung kém

Chặn bot bằng robots.txt không xóa được nội dung khỏi Google và các trang vẫn có thể bị index nếu có liên kết trỏ đến. Thay vì “giấu” nội dung yếu, hãy cải thiện chất lượng hoặc dùng thẻ noindex để ngăn hiển thị trên Google mà vẫn cho phép bot đánh giá toàn diện website. - Đảm bảo sitemap và robots.txt không mâu thuẫn

Nếu sitemap liệt kê URL nhưng robots.txt lại chặn bot, Google sẽ không thể crawl nội dung đó. Hãy đảm bảo mọi URL trong sitemap đều được cho phép truy cập trong robots.txt để quá trình thu thập và lập chỉ mục diễn ra hiệu quả.

5. Kết luận

Sitemap và Robots.txt là hai thành phần kỹ thuật quan trọng trong bất kỳ chiến lược SEO nào, đặc biệt với các website WordPress. Dù đơn giản, chúng đóng vai trò như “bản đồ” và “người gác cổng” giúp Google hiểu rõ đâu là nội dung cần thu thập, đâu là nội dung nên tránh.

Việc sử dụng Sitemap đúng cách giúp đẩy nhanh quá trình index, đảm bảo các trang mới, trang quan trọng được Google phát hiện và lập chỉ mục nhanh chóng. Trong khi đó, Robots.txt giúp kiểm soát quyền truy cập của bot, tránh lãng phí crawl budget vào các khu vực không cần thiết và bảo vệ các phần nội dung không nên công khai.

Nếu được thiết lập hợp lý và duy trì thường xuyên, hai công cụ này sẽ giúp website hoạt động mượt mà hơn trên Google, tránh lỗi kỹ thuật, nâng cao hiệu quả SEO tổng thể và duy trì thứ hạng bền vững trong kết quả tìm kiếm.